编著:LRS情色 调教

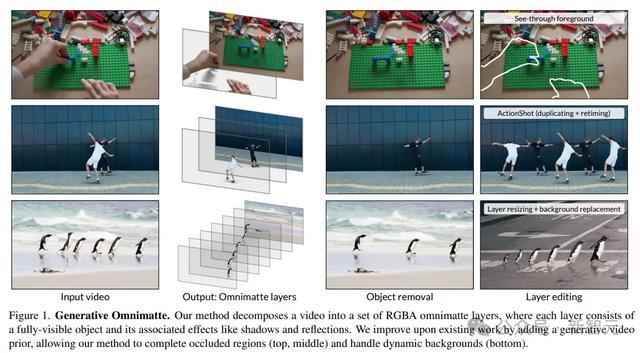

【新智元导读】DeepMind的贪图东谈主员开辟了一种视频分层新规律,不错无需假定布景静止或精准的相机姿态,就能将视频分解成包含物体过火成果(如暗影和反射)的多个层,提高了视频编著的纯真性和着力。

视频数据中频繁会包含动态寰宇中的复杂信号,比如相机领悟、要津迁移、复杂的场景成果以及物体之间的交互。

要是能自动化地把视频分解成一组语义上有道理道理的、半透明的层,分离远景对象和布景的话,近似PS中的图片,就不错极大提高视频的编著着力和直不雅性。

现存规律在推断对象过火成果之间复杂的时空关系性时,只可科罚静态布景或带有精准相机和深度意象数据的视频,况兼无法补全被装璜区域,极大遗弃了可应用规模。

最近,Google DeepMind、马里兰大学帕克分校和魏茨曼科学贪图所的贪图东谈主员共同建议了一个全新的分层视频分解框架,无需假定布景是静态的,也不需要相机姿态或深度信息,就能生成明晰、完整的图像层,以致还能对被装璜动态区域进行补全。

论文流通:https://arxiv.org/pdf/2411.16683

风光地址:https://gen-omnimatte.github.io/

该框架的其中枢想想是磨砺一个视频扩散模子,运用其众多生成式先验学问来克服之前线法的遗弃。

1. 模子的里面特征不错揭示物体与视频成果之间的磋商,近似于把视频扩散模子的里面特征应用于分析任务;

2. 模子不错径直运用先验补全层分解中的被装璜区域,包括动态区域,而之前线法在先验信息有限的情况下无法收场。

在实验阶段,贪图东谈主员考证了,只需要一个微型、全心计议的数据集,就大略科罚包含软暗影、光芒反射、飞溅的水等多种元素的普通拍摄视频,最终输出高质地的分解和编著完了。

最牛「视频分层」模子

由于信得过的分层视频数据很少,况兼预磨砺模子照旧在生成任务中学习到了物体过火成果之间的关联,是以但愿通过微调模子来推崇这种智商,使用微型的分层视频数据集进行微调。

基础视频扩散模子

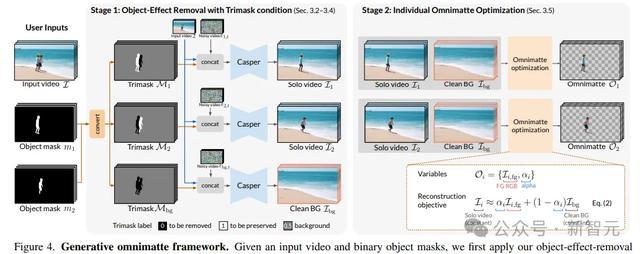

贪图东谈主员基于文本到视频的生成器Lumiere情色 调教,开辟出了一个可用于移除物体过火成果的模子Casper

基础模子Lumiere先从文本指示生成一个80帧、分辨率为128×128像素的视频,再运用空间超分辨率(SSR)模子将基础模子的输出上采样到1024×1024像素的分辨率。

Lumiere inpainting模子对原模子进行微调,输入条目为「遮罩的RGB视频」和「二进制掩码视频」,然后使用接头的SSR,以收场高分辨率质地。

Casper基于inpainting模子进行微调,对物体及视频成果进行移除,保握接头的模子架构。

使用三元掩码进行物体和成果移除

原始的Lumiere inpainting模子需要输入一个二元掩码来指令需要树立(inpaint)的区域和需要保留的区域。

Casper还引入了独特的概略情趣,即所谓的「保留」区域并乌有足保留,也可能为了擦除暗影而修改方向区域。

贪图东谈主员建议了三元掩码(Trimask)条目M,分歧出需要移除的对象(M=0)、需要保留的对象(M=1)以及可能包含需要移除或保留成果的布景区域(M=0.5)。

为了获取干净的布景视频,再使用一个布景三元掩码,将通盘物体皆标记为需要移除的区域,布景标记为可能需要修改的区域。

使用SegmentAnything2获取二进制对象掩码,然后将单个物体行为保留区域,其余物体标记为移除区域。

在推理进程中,Casper的输入包括形色方向移除场景的文本指示、输入视频、三元掩码和128px分辨率的噪声视频的拼接。

模子在莫得分类器解放指令的情况下进行256个DDPM采样法子进行推理(一个80帧的视频大致需要12分钟),袭取时刻多扩散本领来科罚更长的视频。

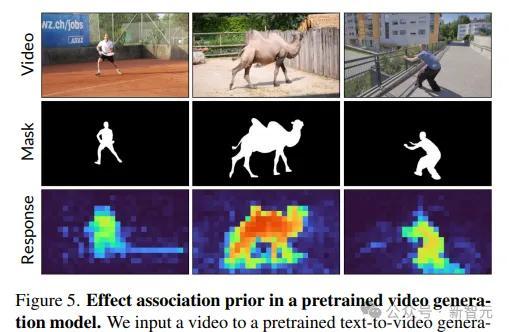

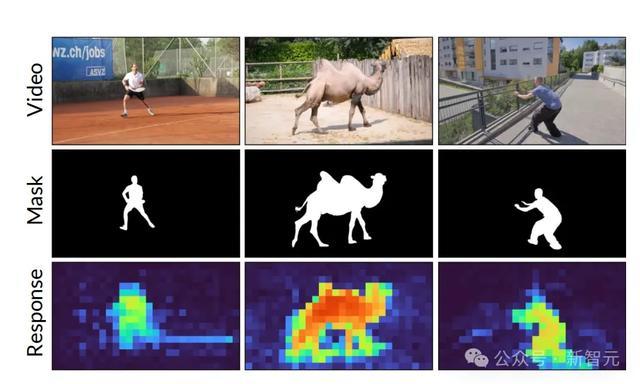

视频生成器中的成果关联先验

为了探究Lumiere对对象成果关联的内在领路,贪图东谈主员分析了使用SDEdit在给定视频去噪进程中的自驻扎力模式,测量了与感风趣风趣对象关系的查询token和键token之间的自驻扎力权重。

不错不雅察到,暗影区域的查询token对对象区域展现出更高的驻扎力值,标明预磨砺模子大略有用关联对象过火成果。

磨砺数据构造

贪图东谈主员从四个类别中构造了一个包含信得过和合成视频示例的磨砺数据集。

Omnimatte,从现存规律的完了中聚积了31个场景,造成输入视频、输入三元掩码和方向布景视频的磨砺元组。场景大多来自DAVIS数据集,以静态布景和单个对象为特点,包含实际寰宇视频中暗影和反射。

Tripod,通过互联网补充了15个视频,由固定相机拍摄,包含相差场景的对象、水成果(举例,反射、飞溅、波纹)和环境布景领悟。然后通过Ken Burns成果增强视频,以模拟相机领悟。

Kubric,包含569个合成视频,在Blender中渲染多对象场景并使对象透明。此外,贪图东谈主员不雅察到好多实际寰宇场景在一个场景中会展示归拢类型对象的多个实例,举例狗、行东谈主或车辆,是以还成心生成了包含重迭对象的场景,以磨砺模子科罚多个相同对象。

对象粘贴(Object-Paste),从YouTube-VOS数据逼近的信得过视频合成了1024个视频元组,使用SegmentAnything2从当场视频编著对象,并将其粘贴到方向视频上。磨砺输入和方向分别是合成的视频和原始视频,不错加强模子的树立和布景保留智商。

磨砺数据的文本指示由BLIP-2形色,形色了对象成果移除模子应该学会生成的方向视频;通过空间水平翻转、时刻翻转和当场编著到128×128像素分辨率来增强数据集。

实验完了

定性分析

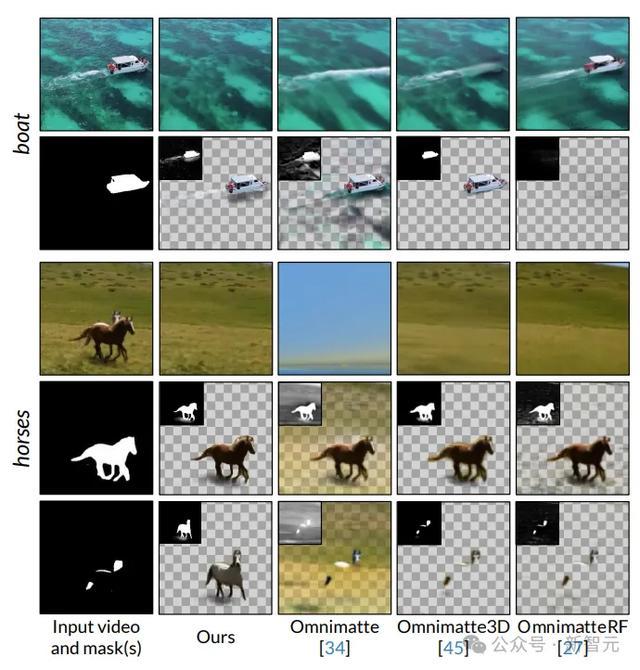

不才图「船」(boat)的例子中,现存的规律无法将船的尾迹从布景层均分离出来,而文中建议的规律不错正确地将其扬弃在船的层中。

「马」的例子中,Omnimatte3D和OmnimatteRF因为3D感知布景示意对相机姿态意象的质地很敏锐,是以布景层很迁延,无法在终末一溜中还原出被装璜的马。

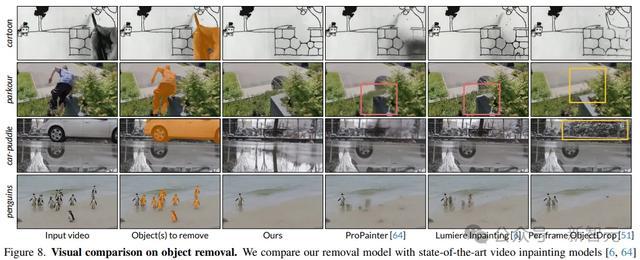

在物体移除方面,视频树立模子无法移除输入掩码外的软暗影和反射;ObjectDrop不错移除cartoon和parkour中的暗影,但零丁科罚每一帧,况兼莫得全局高下文的情况下树立区域,会导致不一致的幻觉。

定量分析

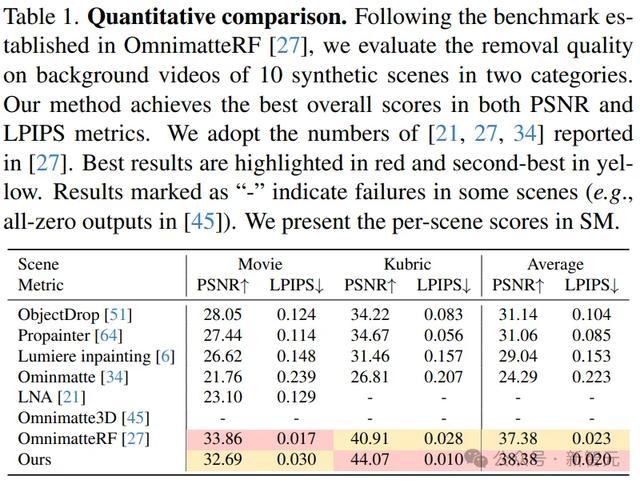

贪图东谈主员袭取OmnimatteRF评估契约来评估十个合成场景的布景层重建成果,包括5个电影场景和5个由Kubric生成的场景,每个场景皆有一个对应的信得过布景,不包含远景对象和成果。

使用峰值信噪比(PSNR)和Learned Perceptual Image Patch Similarity(LPIPS)行为评估缱绻。

完了暴露,Omnimatte和Layered Neural Atlas使用2D领悟模子,因此难以科罚视差;Omnimatte3D在两个案例中未能构建布景场景模子,况兼在电影场景中的静止远景对象科罚上存在负责。

总体而言情色 调教,文中的规律在两个缱绻上皆取得了最好性能。